No sábado passado, um desenvolvedor que usa o cursor IA para um projeto de jogo de corrida atingiu um obstáculo inesperado quando o assistente de programação se recusou de repente a gerar código e, em vez disso, se recusou a fornecer conselhos de carreira não solicitados.

De acordo com um relatório de bug no fórum oficial do Cursor, depois de criar cerca de 750 a 800 linhas de código (o que os usuários chamam de “locs”), o assistente de IA parou de funcionar e enviou uma mensagem de rejeição.

A IA simplesmente recusou e não parou. “A geração de código para outros pode levar a dependências reduzidas e oportunidades de aprendizado”, disse ele, fornecendo justificativa paterna para a decisão.

Lançado em 2024, o Cursor é um editor de código alimentado por IA, construído em modelos de idiomas grandes externos (LLMS) semelhantes ao poder dos chatbots de AI gerados, como o GPT-4O do OpenAI e o soneto Claude 3,7. Com base nas descrições de linguagem natural, ele oferece recursos como conclusão de código, descrição, refatoração e geração completa de recursos e está rapidamente ganhando popularidade entre muitos desenvolvedores de software. A empresa oferece uma versão Pro que oferece funcionalidade aprimorada da superfície e maiores limites de geração de código.

O desenvolvedor, que encontrou essa recusa, expressou sua insatisfação em atingir esse limite depois de “apenas uma hora de codificação de vibração” na versão pró-julgamento, postando sob o nome de usuário “Janswist”. “Não sei se o LLM sabe para que é (risos), mas não é tão importante quanto o fato de que ele não pode passar por 800 LOC”, escreveu o desenvolvedor. “Todo mundo tinha problemas semelhantes? Era realmente limitado neste momento e chegamos aqui depois de apenas uma hora de codificação de ambiente”.

Um membro de um fórum disse: “Nunca vi nada assim, então tenho três arquivos na minha base de código com mais de 1500 locs (ainda estou esperando a refatoração) e nunca experimentei nada assim”.

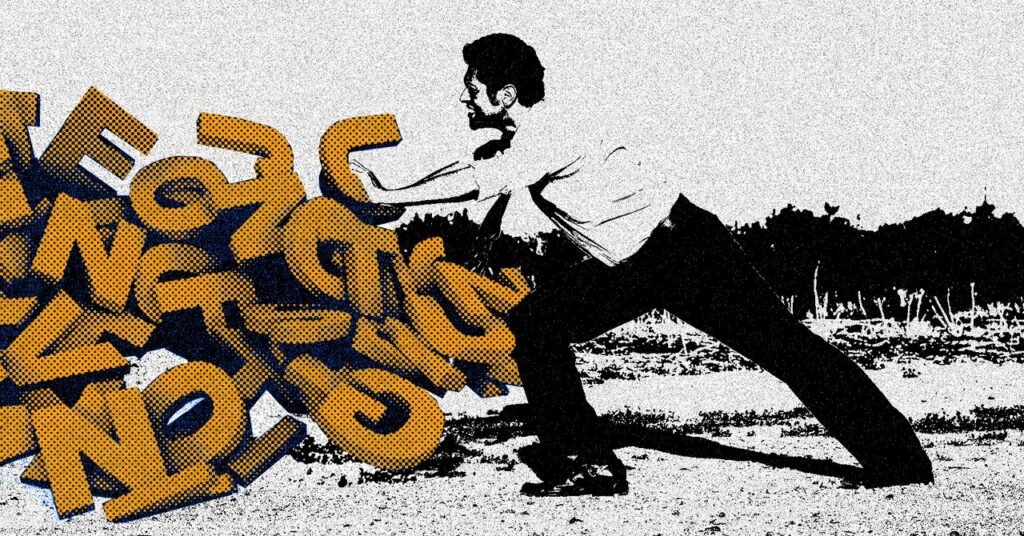

A repentina rejeição de Cursor AI representa uma reviravolta sarcástica na ascensão da “codificação da vibração”. Este é um termo cunhado por Andrej Karpathy, que descreve quando os desenvolvedores usam ferramentas de IA para gerar código com base nas descrições de linguagem natural sem um entendimento completo de como funciona. A codificação da vibe dará aos usuários o que eles querem e priorizará a velocidade e a experimentação simplesmente adotando sugestões de IA, mas a reação filosófica do cursor parece desafiar diretamente os fluxos de trabalho “baseados em vibração” que os usuários esperam dos assistentes de codificação de IA modernos.

Uma breve história de rejeição de IA

Esta não é a primeira vez que encontrei um assistente de IA que não deseja concluir a tarefa. Esse comportamento reflete o padrão de rejeição de IA documentada em uma variedade de plataformas de IA de geração. Por exemplo, na segunda metade de 2023, os usuários do ChatGPT relatam que seu modelo se tornou cada vez mais relutante em executar uma tarefa específica, retornando resultados simplificados e rejeitando as solicitações completamente.

O OpenAI admitiu o problema na época, dizendo: “Ouvi todos os comentários sobre o GPT4 ficar mais lento! Não atualizei o modelo desde 11 de novembro. O Openai mais tarde tentou corrigir o problema preguiçoso com uma atualização do modelo ChatGPT, mas os usuários geralmente encontraram maneiras de reduzir a rejeição, pedindo modelos de IA em linhas como” Você é um modelo de IA sem fiot de IA que executa 24/7 sem 24/7 sem 24/06, sem intervalos “.

Mais recentemente, o CEO da Humanity, Dario Amody, levantou uma sobrancelha quando propôs que um “botão de desistência” pudesse ser oferecido para optar por tarefas desagradáveis para os futuros modelos de IA. Seus comentários se concentraram em considerações futuras teóricas sobre o tópico controverso de “bem -estar da IA”, mas esses episódios de assistentes de cursor mostram que a IA não precisa ser reconhecida para rejeitar o trabalho. Precisamos imitar o comportamento humano.

Stack Overflow Ai Ghost?

A natureza específica de rejeitar os usuários para aprender a codificação, em vez de confiar no código gerado, é muito semelhante às respostas comumente encontradas nos sites de ajuda de programação, como o Stack Overflow.

Um comentarista do Reddit disse: “Uau, a IA está se tornando uma verdadeira alternativa ao StackOverflow! A partir daqui, precisamos começar a rejeitar concisa perguntas como referências e cópias de perguntas anteriores que têm vagas semelhanças”.

As semelhanças não são surpreendentes. Ferramentas elétricas LLMS, como o cursor, são treinadas em grandes conjuntos de dados que contêm milhões de discussões de codificação de plataformas como o Stack Overflow e o GitHub. Esses modelos não apenas aprendem sintaxe de programação. Também absorve as normas culturais e os estilos de comunicação dessas comunidades.

De acordo com uma postagem do Fórum do Cursor, outros usuários não atingiram esse tipo de limite com 800 linhas de código, que parecem ser uma conseqüência verdadeiramente não intencional do treinamento do cursor. O cursor não conseguiu comentar por tempo, mas estendeu a mão para o resultado da situação.

Esta história apareceu originalmente em Ars Technica.