A versão original desta história foi apresentada na revista Quanta.

Modelos de linguagem grandes são tão grandes que funcionam bem. Os modelos mais recentes do OpenAI, Meta e Deepseek usam centenas de bilhões de “parâmetros”. Este é um botão ajustável que determina a conexão entre os dados e é ajustado durante o processo de treinamento. Com mais parâmetros, o modelo é mais poderoso e preciso, pois permite uma melhor identificação de padrões e conexões.

Mas esse poder custa muito. Treinar um modelo com centenas de bilhões de parâmetros requer enormes recursos computacionais. Por exemplo, o Google gastou US $ 191 milhões para treinar o modelo Gemini 1.0 Ultra. Os grandes modelos de idiomas (LLMs) requerem um poder de computação considerável cada vez que eles respondem a uma solicitação. Isso o torna um porco de energia infame. De acordo com o Electric Power Research Institute, uma única consulta no ChatGPT consome cerca de 10 vezes mais energia do que as pesquisas do Google.

Em resposta, alguns pesquisadores agora estão pensando em pequenas idéias. IBM, Google, Microsoft e OpenAI lançaram todos os modelos de idiomas pequenos (SLMs) recentemente que usam bilhões de parâmetros, que são apenas uma pequena parte dos colegas LLM.

Os modelos pequenos não são usados como ferramentas gerais, a menos que sejam grandes. Mas se destaca em certas tarefas estreitamente definidas, como resumir conversas, responder a perguntas dos pacientes como chatbots de assistência médica e coletar dados sobre dispositivos inteligentes. “Para muitas tarefas, o modelo de 8 bilhões de parâmetros é realmente muito bom”, disse Zico Kolter, cientista da computação da Universidade Carnegie Mellon. Ele também pode ser executado em um laptop ou telefone celular em vez de um enorme data center. (Não há consenso sobre a definição exata de “pequena”, mas todos os novos modelos aproveitam ao máximo 10 bilhões de parâmetros.)

Para otimizar o processo de treinamento para esses pequenos modelos, os pesquisadores usam vários truques. Modelos grandes geralmente esfregam dados de treinamento bruto da Internet. Esses dados podem ser organizados, confusos e difíceis de processar. No entanto, esses grandes modelos podem gerar conjuntos de dados de alta qualidade que podem ser usados para treinar modelos pequenos. Essa abordagem, conhecida como destilação do conhecimento, é obtida para aprovar efetivamente o treinamento, assim como os alunos dão aos professores. “O motivo (SLM) é que um modelo tão pequeno pode ser muito bom, e esses dados pequenos usam dados de alta qualidade em vez de bagunçados”, disse Colter.

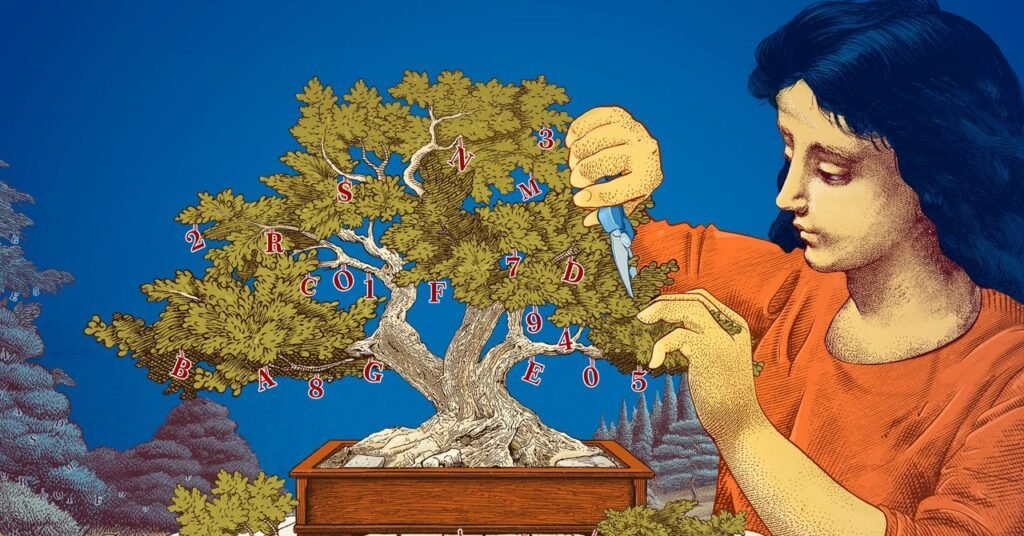

Os pesquisadores também exploraram maneiras de criar pequenos modelos começando com modelos maiores e depois aparando -os. Um método conhecido como poda envolve a remoção de partes desnecessárias ou ineficientes de uma rede neural. Esta é a vasta rede de pontos de dados conectados subjacentes a um modelo grande.

A poda foi inspirada pelas redes neurais reais que são o cérebro humano. Isso ganha eficiência, criando conexões entre sinapses como seres humanos. A abordagem de poda de hoje remonta a um artigo de 1989, onde o cientista da computação Yann Lecun, atualmente na meta, alegou que até 90% dos parâmetros de uma rede neural treinada podem ser removidos sem sacrificar a eficiência. Ele chamou esse método de “dano cerebral ideal”. A poda ajuda os pesquisadores a ajustar os modelos pequenos de linguagem para uma tarefa ou ambiente específico.

Para pesquisadores interessados em como os modelos de idiomas, pequenos modelos oferecem uma maneira barata de testar novas idéias. Além disso, a inferência pode ser mais transparente, pois possui menos parâmetros do que modelos grandes. “Se você deseja criar um novo modelo, precisa experimentar as coisas”, diz Leshem Choshen, cientista de pesquisa do MIT-IBM Watson AI Lab. “O modelo pequeno permite que os pesquisadores experimentem apostas mais baixas”.

Modelos grandes e caros com parâmetros cada vez maiores são úteis para aplicações como chatbots generalizados, geradores de imagens, descoberta de medicamentos e muito mais. No entanto, para muitos usuários, os pequenos modelos de destino funcionam da mesma maneira, mas facilita o treino e a construção dos pesquisadores. “Esses modelos eficientes economizam dinheiro, tempo e cálculos”, disse Choshen.

A história original foi reproduzida com permissão da revista Quanta, uma publicação editorialmente independente da Fundação Simons, cuja missão é aprimorar um entendimento geral da ciência, abrangendo pesquisa e desenvolvimento e tendências em matemática e ciências físicas e da vida.