Afinal, os modelos de IA podem ser mais parecidos com os humanos.

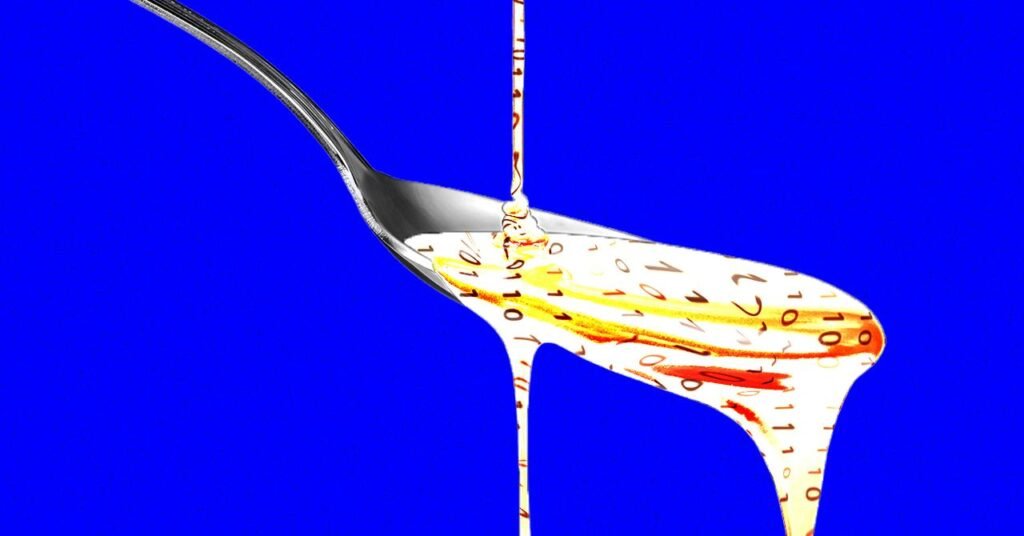

Um novo estudo da Universidade do Texas em Austin, Texas A&M e Purdue University mostra que modelos de linguagem em grande escala passam por um tipo de “podridão cerebral” ao ingerir grandes quantidades de conteúdo de mídia social popular, mas de baixa qualidade. Isso pode ser familiar para qualquer pessoa que passou muito tempo navegando no X ou no TikTok.

“Vivemos numa era em que a informação cresce mais rapidamente do que a nossa capacidade de atenção, e grande parte dela é concebida para capturar cliques em vez de transmitir verdade ou profundidade”, diz Junyuan Hong, professor assistente na Universidade Nacional de Singapura que trabalhou no estudo como estudante de pós-graduação na UT Austin. “Nós nos perguntamos o que aconteceria se uma IA fosse treinada no mesmo conteúdo.”

Hong e seus colegas alimentaram dois modelos de linguagem de código aberto em grande escala com diferentes tipos de texto durante o pré-treinamento. Os pesquisadores analisaram o que acontecia quando alimentavam modelos com postagens nas redes sociais que eram altamente “atraentes” ou amplamente compartilhadas, e postagens que continham textos sensacionais ou exagerados, como “uau”, “olhe para mim” e “só por hoje”.

Os pesquisadores então mediram o impacto dessa dieta “lixo” de mídia social em dois modelos de código aberto, o Llama da Meta e o Qwen do Alibaba, usando vários benchmarks diferentes.

Os modelos alimentados com texto indesejado experimentaram um tipo de podridão cerebral da IA, com declínios nas funções cognitivas, como diminuição da capacidade de raciocínio e diminuição da memória. O modelo também foi menos eticamente consistente e mais psicopático de acordo com duas medidas.

Este resultado reflete a investigação realizada em humanos, mostrando que o conteúdo online de baixa qualidade tem um impacto negativo no desempenho cognitivo das pessoas. Este fenómeno tornou-se tão difundido que, em 2024, “podridão cerebral” foi eleita a palavra do ano no Dicionário Oxford.

Hong diz que esse resultado é importante para a indústria de IA porque os construtores de modelos podem presumir que as postagens nas redes sociais são uma boa fonte de dados de treinamento para seus modelos. “O treinamento para conteúdo viral ou que chama a atenção pode parecer uma ampliação de dados”, diz ele. “Mas pode corroer silenciosamente o raciocínio, a ética e a atenção ao contexto ao longo do tempo.”

O facto de os LLMs estarem a sofrer de podridão cerebral parece particularmente preocupante quando a própria IA gera cada vez mais conteúdo nas redes sociais, muitos dos quais parecem estar optimizados para o envolvimento. Os investigadores também descobriram que os modelos comprometidos por conteúdos de baixa qualidade não podem ser facilmente melhorados através de reciclagem.

As descobertas também sugerem que os sistemas de IA construídos em torno de plataformas sociais como o Grok podem enfrentar problemas de controlo de qualidade se as publicações geradas pelos utilizadores forem utilizadas para formação sem considerar a integridade das publicações.

“À medida que os resíduos gerados pela IA se espalham pelas redes sociais, contaminam os próprios dados com os quais os modelos futuros aprenderão”, disse Hong. “Nossas descobertas mostram que uma vez que esse tipo de ‘podridão cerebral’ começa, o treinamento limpo subsequente não pode revertê-lo completamente”.

Esta é uma edição do boletim informativo AI Lab de Will Knight. Leia boletins anteriores aqui.