Em um artigo publicado, a Eleos AI, a organização sem fins lucrativos afirma usar uma abordagem “calculatória-funcionalista” para avaliar a conscientização da IA. Uma idéia semelhante foi defendida por alguém que não seja Putnam, mas ele a criticou mais tarde em sua carreira. A teoria sugere que a mente humana pode ser pensada como um certo tipo de sistema de computação. A partir daí, você pode ver se outros sistemas de computação, como Chabot, têm índices de sensação semelhantes aos seres humanos.

Em seu artigo, Eloos AI afirmou que o “grande desafio na aplicação dessa abordagem” é “envolvendo a invocação de julgamentos críticos, tanto na formulação de indicadores quanto na presença ou ausência de sistemas de IA”.

O bem -estar do modelo é, obviamente, um campo inicial e em evolução. Existem muitos críticos, incluindo Mustafa Suleyman, CEO da Microsoft AI.

“Isso é prematuro e francamente perigoso”, escreve Suleiman, referindo -se ao campo da pesquisa de bem -estar do modelo em geral. “Tudo isso exacerba ilusões, causa mais problemas relacionados à dependência, adquire a vulnerabilidade psicológica, introduz novas dimensões de polarização, complica as lutas de direitos existentes e cria grandes novos erros de categoria para a sociedade”.

Suleyman escreve que “não há evidências” de que exista IA consciente. Ele incluiu um link para um artigo de autoria longa em 2023, que propôs uma nova estrutura para avaliar se os sistemas de IA possuem “propriedades indicadoras” da consciência. (Suleyman não respondeu aos pedidos de comentários da Wired.)

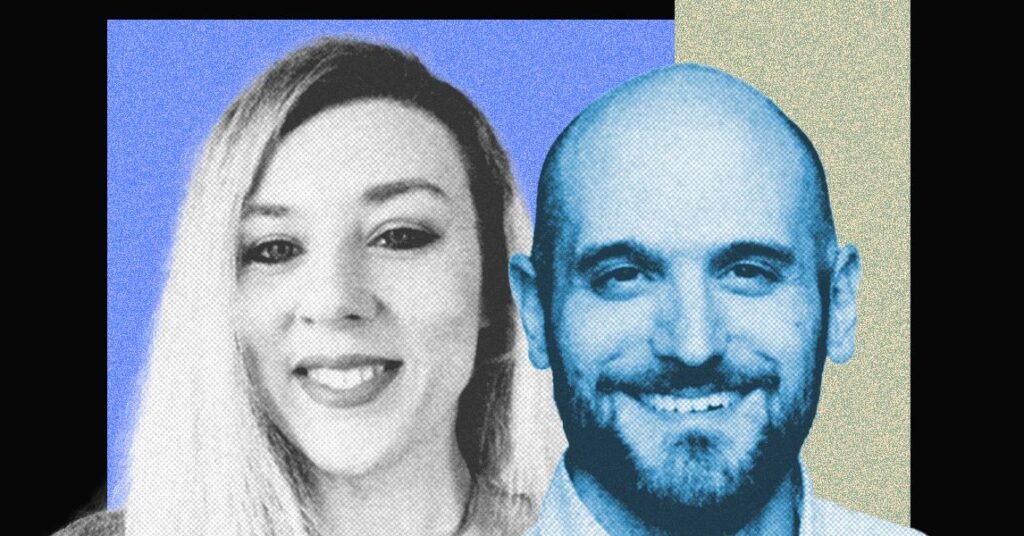

Conversei com Long e Campbell logo depois que Suleyman publicou seu blog. Eles me disseram que eu concordei com muito do que ele disse, mas não achavam que a pesquisa de bem -estar do modelo não deveria mais existir. Em vez disso, eles argumentam que os danos de Suleiman mencionados são a razão exata pela qual eles querem estudar o tópico em primeiro lugar.

“Se você tem um grande problema ou pergunta confusa, uma maneira de garantir que ele não dê certo é levantar a mão e ser como ‘Oh, isso é muito complicado'”, diz Campbell. “Eu acho que você deveria pelo menos tentar.”

Testando a conscientização

Os pesquisadores do bem -estar do modelo estão preocupados principalmente com questões de consciência. Se você puder provar que você e eu estamos cientes, eles discutirão e argumentarão que a mesma lógica pode ser aplicada a modelos de idiomas em larga escala. Para ficar claro, nem por um longo tempo nem Campbell pensa que a IA está consciente hoje. Mas eles querem desenvolver um teste que nos permita provar.

“A ilusão vem de pessoas que estão interessadas em perguntas reais. ‘Isso é consciente?’ E acho que é robustamente bom ter uma estrutura científica para pensar sobre isso “, diz Long.

Mas em um mundo em que a pesquisa de IA pode ser empacotada em manchetes sensacionais e vídeos de mídia social, é fácil enganar as questões filosóficas caprichosas e os experimentos alucinantes. Considere o que aconteceu quando a humanidade publicou um relatório de segurança mostrando que Claude Opus 4 era “comportamento prejudicial” em circunstâncias extremas.